最新下载

热门教程

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

黄仁勋给 Nokia 10 亿美元背后:想赚 2000 亿的野心

时间:2025-10-30 19:20:13 编辑:袖梨 来源:一聚教程网

黄仁勋在 2025 GTC 上宣布英伟达将投资诺基亚 10 亿美元,共同开发 AI-RAN 技术,瞄準价值 2000 亿美元的 RAN 市场。

(前情提要:辉达砸10亿美元入资诺基亚成最大股东!Nokia大涨21%,黄仁勋背后在打什么主意? )

(背景补充:Nokia 将推出 Web3 手机?申请数位资产加密专利,看好区块链发展 )

本文目录

- 什么是 AI-RAN?

- 放眼 2025 年,英伟达真的投了不少钱。

- 当然,这场 GTC 上黄仁勋还说了很多。

在 2025 年的 GTC 上,黄仁勋放出了一个猛料,英伟达将投资诺基亚 10 亿美元。对,就是那个 20 年前火遍大江南北的塞班手机公司诺基亚。

黄仁勋在演讲中说,电信网路正处于从传统架构向 AI 原生系统的重大转变中,而英伟达的投资将加速这一进程。于是英伟达就以投资的方式,和诺基亚共同创建一个面向 6G 网路的 AI 平台,把 AI 赋能到传统的 RAN 网路中。

具体的投资形式是英伟达以每股 6.01 美元的价格认购诺基亚约 1.66 亿股新股,这将使英伟达持有诺基亚约 2.9% 的股权。

就在宣布合作的一剎那,诺基亚股价上涨了 21%,是 2013 年以来的最大涨幅。

什么是 AI-RAN?

RAN 就是无线接入网,而 AI-RAN 将 AI 计算能力直接嵌入到无线基站中的新型网路架构。传统的 RAN 系统主要负责在基站和移动设备之间传输资料,而 AI-RAN 则在此基础上增加了边缘计算和智慧处理功能。

让基站能够应用 AI 演算法来优化频谱利用率和能源效率,改善整体网路效能,同时还能利用闲置的 RAN 资产託管边缘 AI 服务,为营运商创造新的收入来源。

营运商可以在基站现场直接运行 AI 应用,而不必将所有资料传回中心资料中心处理,大大减少了网路的负担。

黄仁勋举了个例子,几乎 50% 的 ChatGPT 使用者都是透过移动设备进行存取,不仅如此,ChatGPT 的月度移动下载量超过了 4000 万,在 AI 应用爆炸式成长的年代,传统的 RAN 系统没办法应对生成式 AI 以及智慧体主导的移动网路。

而 AI-RAN 透过在边缘提供的分散式 AI 推理能力,让接下来的 AI 应用,比如智慧体、聊天机器人回应更快。同时,AI-RAN,也是为 6G 时代的整合感测和通讯应用做好準备。

黄仁勋引用了分析师公司 Omdia 的预测,该公司预计 RAN 市场到 2030 年将累计超过 2000 亿美元,其中 AI-RAN 部分将成为成长最快的细分领域。

诺基亚总裁兼执行长贾斯汀·霍塔德在联合声明中表示,这一伙伴关係将把 AI 资料中心放入每个人的口袋中,实现从 5G 到 6G 的根本性重设计。

他特别提到,诺基亚正在和英伟达、戴尔、T-Mobile 这三家不同类型的企业合作。T-Mobile 作为首批合作伙伴,将从 2026 年开始进行 AI-RAN 技术的实地测试,重点验证效能和效率提升。贾斯汀说这项测试将为 6G 创新提供宝贵资料,帮助营运商构建适应 AI 需求的智慧网路。

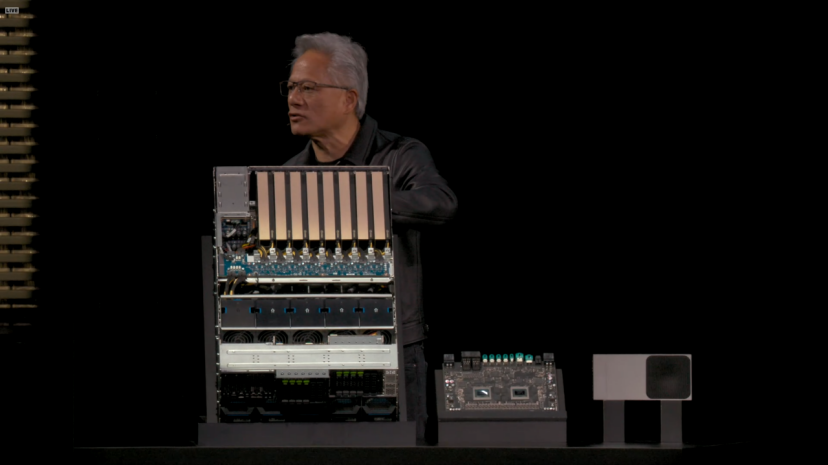

基于 AI-RAN,英伟达发布的新产品叫做 Aerial RAN Computer Pro(ARC-Pro),这是一个为 6G 準备的加速计算平台。它的核心硬体配置同时包含了英伟达的两种 GPU:Grace CPU 和 Blackwell GPU。

这个平台透过 NVIDIA CUDA 运行,RAN 软体可以直接嵌入到 CUDA 技术栈中。因此,它不仅能处理传统的无线接入网功能,还能同时运行主流的 AI 应用。这也是英伟达实现 AI-RAN 中 AI 两个字母的核心方法。

鉴于 CUDA 悠久的历史,这个平台的最大优势其实是可程式性。不止是这样,黄仁勋还宣布将 Aerial 软体框架开源,预计从 2025 年 12 月开始在 GitHub 上以 Apache 2.0 许可证发布。

ARC-Pro 与其前代产品 ARC 的主要区别在于部署位置和应用场景。前代 ARC 主要用于集中式云 RAN 实现,而 ARC-Pro 则可以直接部署在基站现场,这使得边缘计算能力得以真正落地。

英伟达电信业务负责人罗尼·瓦希塔说,过去 RAN 和 AI 需要两套不同的硬体才能实现,但是 ARC-Pro 可以根据网路需求动态分配计算资源,既可以优先处理无线接入功能,也可以在闲置时段运行 AI 推理任务。

ARC-Pro 还整合了英伟达 AI Aerial 平台,这是一个完整的软体栈,包括 CUDA 加速的 RAN 软体、Aerial Omniverse 数位孪生工具和新的 Aerial Framework。Aerial Framework 可以将 Python 程式码转换为高效能的 CUDA 程式码,在 ARC-Pro 平台上运行。此外,平台还支援 AI 驱动的神经网路模型,用于高级通道估计。

黄仁勋说,电信是经济和安全的数位神经系统。与诺基亚和电信生态系统的合作,将点燃这一革命,帮助营运商构建智慧、适应性的网路,定义下一代全球连接。

放眼 2025 年,英伟达真的投了不少钱。

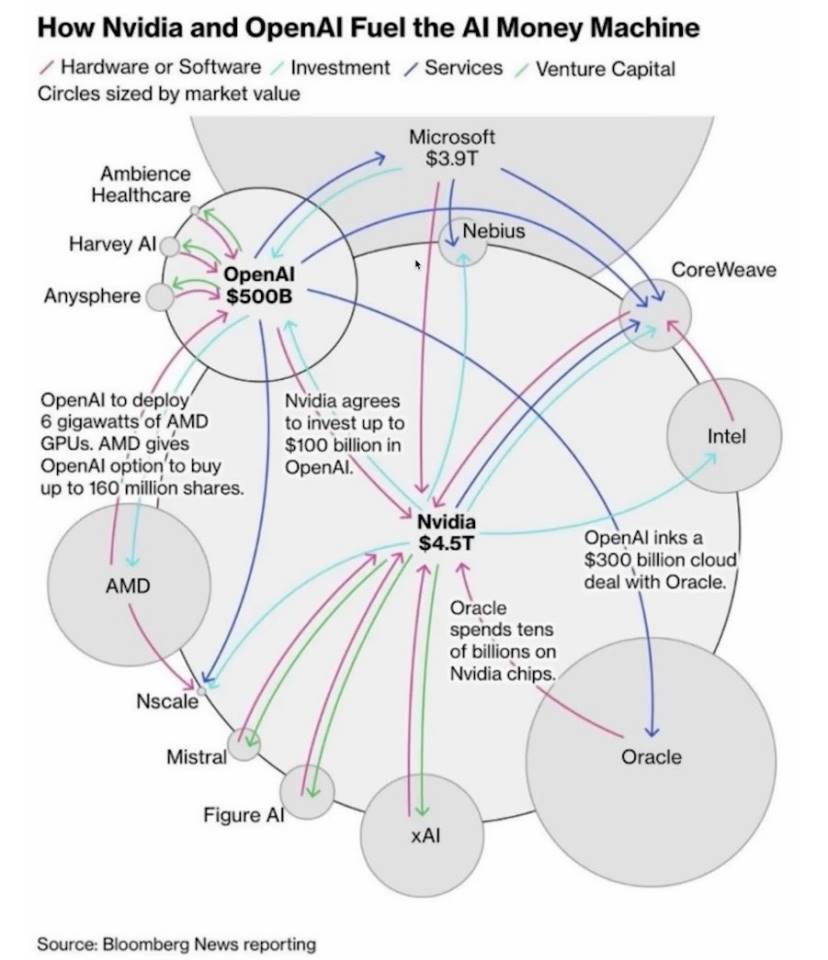

9 月 22 日,英伟达和 OpenAI 达成合作,英伟达计划逐步向 OpenAI 投资 1000 亿美元,这将加速其基础设施建设。

黄仁勋说,其实 OpenAI 很久前就寻求英伟达的投资,但当时公司资金有限。他幽默地说,当时太穷,其实应该把所有钱都给他们。

黄仁勋认为,AI 推理成长不是 100 倍或 1000 倍,而是 10 亿倍。而且这一合作不仅限于硬体,还包括软体优化,确保 OpenAI 能高效利用英伟达的系统。

这可能是因为他在了解到 OpenAI 和 AMD 合作后,担心 OpenAI 放弃 CUDA。一旦全球最大的 AI 基础大模型不使用 CUDA,那么其他大模型厂商效仿 OpenAI,也是情理之中的事情。

黄仁勋在 BG2 播客节目中预测,OpenAI 很可能成为下一个兆美元市值的公司,其成长速度将创下行业纪录。他反驳了 AI 泡沫论,指出全球每年在 AI 基础设施上的资本支出将达到 5 兆美元。

也正是因为这笔投资,OpenAI 在 10 月 29 日宣布完成公司资本重组。公司被拆分成了两部分,一部分是非营利基金会,另一部分就是营利性公司。

非营利性质的基金会将在法律上控制营利性的部分,且必须兼顾公共利益。但是依然可以放开手脚去融资或收购公司。基金会将拥有这家营利性公司 26% 的股份,并持有一份认股权证。如果公司继续发展壮大,基金会还能获得额外股份。

除了 OpenAI,英伟达在 2025 年还投资了马斯克的 xAI。这家公司当前融资轮次规模提升至 200 亿美元。其中约 75 亿美元透过股权募集,至多 125 亿美元透过特殊目的实体(SPV)的债权募集。

这个特殊目的实体的运作方式是,它将使用募集到的资金购入英伟达的高效能处理器,然后将这些处理器出租给 xAI 使用。

这些处理器将被用于 xAI 的 Colossus 2 项目。Colossus 初代是 xAI 位于田纳西州孟菲斯的超级计算资料中心。Colossus 初代项目已经部署了 10 万个英伟达 H100 GPU,使其成为全球最大的 AI 训练丛集之一。现在 xAI 正在建设的 Colossus 2,计划将 GPU 数量扩展到数十万甚至更多。

9 月 18 日,英伟达还宣布将向英特尔投资 50 亿美元,并建立深度战略合作关係。英伟达将以每股 23.28 美元的价格认购英特尔新发行的普通股,总投资额达 50 亿美元,交易完成后,英伟达将持有英特尔约 4% 的股份,成为其重要战略投资者。

当然,这场 GTC 上黄仁勋还说了很多。

比如英伟达推出了多个开源 AI 模型家族,包括用于数位 AI 的 Nemotron、用于物理 AI 的 Cosmos、用于机器人的 Isaac GR00T 和用于生物医学 AI 的 Clara。

同时,黄仁勋推出了 DRIVE AGX Hyperion 10 自动驾驶开发平台。这是一个面向 4 级自动驾驶的平台,整合了英伟达计算晶片和完整的感测器套件,包括雷射雷达、摄像头和雷达。

英伟达还推出了 Halos 认证计划,这是行业首个用于评估和认证物理 AI 安全性的系统,专门针对自动驾驶车辆和机器人技术。

Halos 认证计划的核心是 Halos AI 系统,这是行业首个获得 ANSI 认证委员会认可的实验室。而 ANSI 是美国国家标準协会,其认证具有很高的权威性和公信力。

这个系统的任务是透过英伟达的物理 AI,来检测自动驾驶系统是否符合标準。AUMOVIO、Bosch、Nuro 和 Wayve 等公司是 Halos AI 系统检验实验室的首批成员。

为了推动 4 级自动驾驶,英伟达发布了一个从 25 个国家手的多模态自动驾驶资料集,里面包含了 1700 小时的摄像头、雷达和雷射雷达资料。

黄仁勋说这个资料集的价值在于其多样性和规模,它涵盖了不同的道路条件、交通规则和驾驶文化,为训练更加通用的自动驾驶系统提供了基础。

不过黄仁勋的蓝图远不止于此。

他在 GTC 上宣布了一系列与美国政府实验室和领先企业的合作,目标是构建美国的 AI 基础设施。黄仁勋说,我们正处于 AI 工业革命的黎明,这将定义每个行业和国家的未来。

这次合作的重头戏是与美国能源部的合作。英伟达正在帮助能源部建设两个超级计算中心,一个在阿贡国家实验室,另一个在洛斯阿拉莫斯国家实验室。

阿贡实验室将获得一个名为 Solstice 的超级计算机,这个系统配备了 10 万个英伟达 Blackwell GPU。10 万个 GPU 是什么概念?这将是能源部有史以来最大的 AI 超级计算机。另外还有一个叫 Equinox 的系统,配备 1 万个 Blackwell GPU,预计 2026 年投入使用。这两个系统加起来能提供 2200 exaflops 的 AI 计算效能。

阿贡实验室主任保罗·科恩斯说,这些系统将重新定义效能、可扩展性、可靠性和科学潜力。他们要用这些算力来做什么?从材料科学到气候建模,从量子计算到核武器模拟,都需要这种级别的计算能力。

除了政府实验室,英伟达还在维吉尼亚州建了一个 AI 工厂研究中心。这个中心的特别之处在于,它不只是一个资料中心,而是一个实验场。英伟达要在这里测试一个叫 Omniverse DSX 的东西,这是一个用于建设千兆瓦级 AI 工厂的蓝图。

一个普通资料中心可能只需要几十兆瓦的电力,而千兆瓦相当于一个中等规模核电站的发电量。

这个 Omniverse DSX 蓝图的核心思想是让 AI 工厂变成一个自学习系统。AI 代理会持续监控电力、冷却和工作负载,自动调整参数来提高效率。比如当电网负荷高的时候,系统可以自动降低功耗,或者切换到储能电池供电。

这种智慧化管理对于千兆瓦级的设施来说至关重要,因为电费和冷却成本会是天文数字。

这个愿景很宏大,黄仁勋说他需要三年才能实现。AI-RAN 测试要在 2026 年才能开始,基于 DRIVE AGX Hyperion 10 的自动驾驶汽车要到了 2027 年才能上路,能源部的超级计算机也是 2027 年投入使用。

英伟达手握 CUDA 这个杀手锏,掌握着 AI 计算的事实标準。从训练到推理,从资料中心到边缘设备,从自动驾驶到生物医学,英伟达的 GPU 无处不在。这次 GTC 上宣布的这些投资和合作,进一步巩固了这个地位。